Premier tour d’horizon de l’AI Act

Dit artikel is ook beschikbaar in het Nederlands.

Note : il s’agit d’un article de vulgarisation consacré à une réglementation future, basé sur la publication officielle du 12/07/2024. Adressez-vous toujours à un·e juriste pour obtenir un avis juridique professionnel.

L’AI Act européen (en français le règlement sur l’intelligence artificielle) est une des pierres angulaires d’une série d’initiatives législatives à grande échelle destinées à réglementer l’économie numérique en Europe. Il vient ainsi compléter la législation antérieure relative à certains aspects de l’intelligence artificielle, comme le RGPD, le Digital Services Act (DSA) et le Digital Markets Act (DMA), le Data Act, le Data Governance Act, le CHIPS Act et le Cyber Resilience Act en cours d’élaboration. Après de longues négociations, l’AI Act a été approuvé par le Parlement européen en mars 2024 et par le Conseil européen en mai 2024. La publication au Journal officiel de l’Union européenne, que l’on peut appeler Moniteur européen, a eu lieu le 12 juillet 2024. Les premières règles entreront en vigueur début 2025. Vous pouvez également consulter cette chronologie.

Un RGPD bis ?

Le texte intégral de l’AI Act, y compris l’ensemble des préliminaires et annexes, comprend 144 pages. Fort heureusement, de bons résumés sont déjà disponibles ici et là. Il est ainsi presque deux fois plus long que le RGPD qui ne fait, lui, “que” 88 pages. L’impact de ce dernier est énorme : toutes les organisations traitant des données à caractère personnel – il suffit d’avoir une administration du personnel ou un fichier de clients – se sont en effet vues confrontées aux exigences relatives aux délégués à la protection des données, aux registres de traitement et aux bases juridiques du traitement des données. Chaque pays a également dû mettre en place une Autorité de protection des données habilitée à infliger des amendes en cas d’infraction.

Le RGPD s’est également accompagné d’une certaine confusion, notamment par son utilisation fréquente de termes ouverts à l’interprétation (“approprié”, “adéquat”, “adapté”, “suffisant”…).

La nécessité de les concrétiser à nouveau pour chaque cas d’espèce alimente ce que l’on peut aujourd’hui appeler une petite industrie juridique. L’AI Act vise à fournir un peu plus d’indications, en revêtant une forme plus technique. Il comporte ainsi une liste d’annexes avec des énumérations pratiques des attentes en matière de documentation, de conformité, de transparence, etc.

L’AI Act est parti d’une proposition plus compacte de 125 pages (annexes incluses). Au cours des négociations cependant, on a assisté à l’essor fulgurant de l’IA générative et des grands modèles de langage. Cette nouvelle donne a nécessité la révision et l’ajout de certains éléments, tels qu’un nouveau chapitre (5) entièrement consacré aux modèles d’IA à usage général, parmi lesquels on compte les grands modèles de langage. Quant à certaines sections, on peut se demander ce qu’elles viennent faire dans l’AI Act, notamment un système de “bacs à sable réglementaires de l’IA” (article 57) qui doit permettre aux régulateurs de faciliter l’innovation. Certains articles sont formulés de manière plutôt énigmatique, comme la section dédiée aux “organismes d’évaluation de la conformité notifiés” (article 29), qui ne sont ni plus ni moins que des auditeurs. Des voix critiques se font donc entendre, craignant que la somme de mesures qui en résulte ne débouche avant tout sur un véritable imbroglio.

AI Act – Fondamentaux

L’AI Act s’adresse aux développeurs et aux fournisseurs d’IA, et ce uniquement lorsqu’ils publient des systèmes d’IA et les mettent à la disposition de tiers. Tous les développements et tests internes préalables sont explicitement exemptés (article 2 §8). L’AI Act ne s’applique pas non plus aux activités personnelles auxquelles vous vous adonnez dans un contexte non professionnel (article 2 §10). De même, la recherche scientifique (article 2 §6) et les applications militaires (article 2 §3) ne sont pas concernées. Bien évidemment, cela ne signifie pas que tout est permis dans tous ces cas.

Il va de soi que d’autres législations existantes restent en vigueur. Les droits des citoyens étaient déjà protégés par l’article 22 du RGPD entre autres, tandis que la législation sur les droits d’auteur continue de protéger les auteurs.

Par ailleurs, la définition de l’IA utilisée est particulièrement large et empruntée à l’OCDE : en résumé, “un système IA […] déduit, à partir des entrées, la manière de générer des sorties […]” (article 3 + considérant 12). La quasi-totalité de l’apprentissage automatique entre dans ce cadre. Dans d’autres définitions, on lit parfois que l’IA comporte un aspect cognitif (quelque chose doit être “reconnu”), mais il n’en est pas fait mention ici. Il n’est pas non plus fait mention de techniques spécifiques : tout ce qui apprend de manière adaptative ou peut réagir de manière quelque peu autonome à l’environnement est presque toujours inclus. Il s’agit donc également des systèmes que vous connaissez depuis des années, sans vous rendre compte qu’ils reposent sur l’intelligence artificielle, tels que les filtres antispam, les recommandations sur les sites web, voire les prévisions météorologiques.

L’AI Act définit d’abord et surtout une liste de pratiques interdites (article 5), qui prendra effet dès le début de l’année 2025. Cette liste est exhaustive, ce qui signifie en principe que tout ce qui n’est pas explicitement interdit est autorisé (sauf dispositions contraires prévues par d’autres lois). Aussi est-il intéressant d’examiner ce qui figure et ce qui ne figure pas dans cette liste d’interdictions, ainsi que les dispositions supplémentaires qui s’y rapportent. On découvre ainsi que :

- §1(f) : L’interdiction de la reconnaissance des émotions ne mentionne que le lieu de travail et l’enseignement.

- §1(g) : L’interdiction des systèmes d’IA biométriques ne mentionne que la déduction automatique concernant la race, la sexualité, l’affiliation à une organisation syndicale, la religion, les convictions politiques et philosophiques.

- §1(e) : L’interdiction de la reconnaissance faciale ne concerne que les systèmes basés sur ce qu’on appelle “moissonnage non ciblé”.

Elle est donc plus nuancée qu’une liste d’interdictions générales, car le contexte et l’objectif interviennent également. La reconnaissance des émotions dans les jeux vidéo, par exemple, reste ainsi autorisée. Les considérants 15 à 17 précisent que l’IA biométrique reste autorisée pour la vérification d’identité et l’authentification. Parallèlement, des exceptions sont prévues entre autres pour l’assistance médicale et la lutte contre la criminalité, bien que ces exceptions soient soumises à un contrôle strict (article 5, §2-§7), y compris une liste des infractions pénales qui entrent en ligne de compte (annexe 2).

Les systèmes qui assurent la sécurité des utilisateurs ou qui sont énumérés à l’annexe 3 sont des systèmes à haut risque (article 6). Il s’agit principalement de systèmes susceptibles d’avoir un impact majeur sur les libertés, la vie, la carrière ou la santé d’un individu. Bien que cette section de l’AI Act n’entrera en vigueur qu’à l’été 2026, il convient de noter qu’il subsiste des lacunes à combler. Par exemple, la Commission doit encore fournir des lignes directrices précisant l’interprétation de cet article (article 6 §5) et se réserve le droit d’apporter des modifications même après coup (article 6 §6-§8, article 7).

AI Act – Obligations

Quiconque souhaite construire ou a construit un système à haut risque devra se conformer à une série d’obligations, qui doivent notamment permettre aux autorités compétentes d’intervenir en cas de non-respect. Les développeurs de systèmes à haut risque devront adopter certaines pratiques, notamment :

- Un système itératif de gestion des risques (article 9), qui doit permettre d’identifier et d’évaluer les risques et d’atténuer les abus potentiels à l’avance. Le texte est relativement peu concret : il parle de “risques raisonnablement prévisibles” et de “mesures appropriées” sans autre précision. Ceci fera donc encore l’objet de discussions, mais dans la pratique, on peut déjà aujourd’hui se contenter en partie des normes récemment élaborées à cette fin, telles que la norme ISO/IEC 42001. Étant entendu qu’elle n’est pas explicitement conçue pour la loi sur l’IA Act, des mesures supplémentaires peuvent s’imposer.

- La gestion de données de qualité (article 10), qui se résume en grande partie à la transparence sur l’origine, les limites, les marges d’erreur et la représentativité. L’utilisation de Data Sheets (fiches de données), dont c’est l’objectif, est devenue populaire dans le secteur au cours des dernières années.

- Fournir une documentation technique conforme aux exigences de l’annexe 4 (annexe 11 pour l’IA à usage général). Ceci est quelque peu analogue aux Model Cards (cartes modèles) que l’on peut trouver sur le HuggingFace Hub, bien que la Commission européenne ne se contente pas de listes cochées et exige plus de détails, y compris sur la surveillance et le contrôle pendant la durée de vie du système.

- L’enregistrement (article 12) ainsi que la transparence et la fourniture d’informations aux utilisateurs (article 13).

- Le contrôle humain pendant la durée de vie du système (article 14). Si l’article 22 du RGPD en faisait déjà un droit civil, l’AI Act impose aux développeurs de prendre les mesures nécessaires à cette fin. Par exemple, il devra toujours être possible d’ignorer, de remplacer ou d’arrêter le système d’IA (article 14 §4 (d-e)).

- Prendre des mesures “appropriées” en matière de cybersécurité, de robustesse et d’exactitude (article 15). Cet article reste lui aussi relativement vague à l’heure actuelle et fait référence à l’intention de la Commission de soutenir le développement des étalonnages nécessaires.

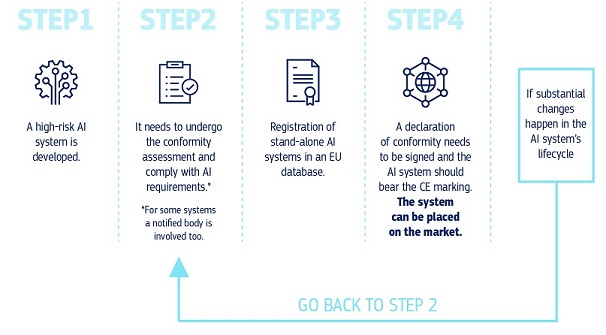

Quiconque publie, met à disposition, incorpore dans son propre produit, importe ou distribue un système à haut risque devra prendre des mesures similaires, notamment :

- Vérifier et prouver la conformité du système (article 16 §e-l, articles 40-47), établir une déclaration de conformité (annexe 5) et obtenir le marquage CE (article 48).

- Utiliser un système de gestion de la qualité (article 17).

- Conserver la documentation nécessaire pendant 10 ans après la mise en service (article 18).

- Coopérer avec les autorités compétentes (article 21).

- Enregistrer le système (article 49) dans une base de données européenne dédiée (article 71).

- Désigner une personne de contact ou un représentant pour tout ce qui précède (article 22).

- Mettre en place la surveillance nécessaire et agir en cas de problème (article 26 §5 et articles 72-73), notamment en informant l’autorité compétente.

Par analogie avec l’analyse d’impact relative à la protection des données du RGPD, certaines organisations, dont toutes les autorités publiques et les organisations de service public, devront réaliser une analyse d’impact sur les droits fondamentaux (Fundamental Rights Impact Assessment ou FRIA) dont les résultats devront être communiqués aux régulateurs du marché compétents (article 27). L’AI Office européen est déjà chargé de développer les questionnaires automatisés nécessaires à l’acquittement de cette obligation (article 27 §5).

On en oublierait presque que la grande majorité des systèmes d’IA sont simplement des systèmes à faible risque. À cet égard, l’AI Act est assez succinct : ils doivent satisfaire à des exigences minimales de transparence uniquement pour des applications spécifiques (article 50). Ainsi, l’utilisateur final doit toujours savoir qu’il interagit avec un système d’IA, et les résultats générés artificiellement doivent être clairement identifiés comme tels. La mainmise redoutée sur l’ensemble de l’industrie de l’IA est donc toute relative.

IA à usage général

Le développement récent de l’IA générative à usage général pour le texte et les images a nécessité l’ajout d’une catégorie distincte de systèmes, à savoir l’IA à usage général. La Commission européenne considère que ce type d’IA, indépendamment d’un éventuel risque élevé en matière de droits civils, peut également présenter un risque systémique (article 51). Le bien-fondé ou non de cette position fait l’objet d’un débat acharné dans les cercles techniques et philosophiques, mais l’UE adopte une approche prudente et prévoit un bâton juridique.

La Commission européenne se donne la liberté de déterminer les systèmes qui présentent un tel risque (article 51 §1). Bien qu’elle affirme appliquer des critères objectifs pour ce faire (annexe 13), il n’y a pas de véritable formule. Néanmoins, l’article 51 §2 fixe étonnamment une limite très concrète, à savoir qu’à partir du moment où son entraînement requiert une puissance de calcul de 1025 FLOPS, un modèle d’IA à usage général est par définition considéré comme présentant un risque systémique. Cela correspond approximativement à un temps d’entraînement d’un an sur un cluster de 4000 GPU de type Nvidia RTX4090 (avec une puissance de calcul de 82×1012 FLOPS). Pour éviter que tout cela ne devienne obsolète demain, la Commission se réserve le droit d’adapter ces valeurs à l’avenir en fonction des évolutions du domaine (article 51 §3).

Outre les exigences minimales de l’article 50 et indépendamment de la classification des risques, l’IA à usage général est soumise à son propre ensemble d’exigences en matière de documentation technique (article 53, annexe 11), qui seront un peu élargies en présence d’un risque systémique (article 55). Les constructeurs de modèles d’IA à usage général sans risque systémique publiés sous licence libre sont exemptés de certaines obligations (article 53 §2, voir également les considérants 102 à 104) et ne sont pas non plus tenus de désigner une personne de contact ou un représentant (article 54 § 6).

AI Office (Bureau de l’IA)

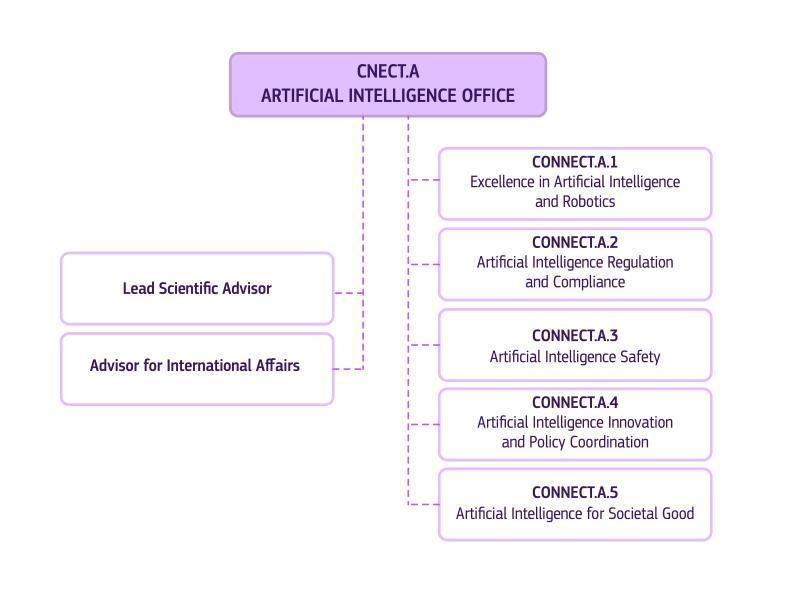

L’AI Act devra également être appliqué. Un rôle majeur dans ce cadre sera joué par l’AI Office (Bureau de l’IA, article 64), qui devrait être à l’AI Act ce que le Contrôleur européen de la protection des données est au RGPD. L’AI Office est actuellement mis en place à grande vitesse, les premières dispositions entrant en vigueur début 2025. Outre la responsabilité de compléter une série d’articles en suspens de l’IA Act, l’AI Office se verra confier la compétence exclusive de la surveillance de l’IA à usage général (article 75).

En pratique, l’AI Office fera partie de la DG CONNECT, commencera avec 140 collaborateurs et sera dirigé par Lucilla Sioli. Il sera soutenu dans son fonctionnement par le Centre européen pour la transparence algorithmique (ECAT), un Comité AI (article 65), un forum consultatif des parties prenantes (article 67) et un groupe scientifique d’experts indépendants (article 68).

Des régulateurs doivent également être désignés au niveau national (article 70). Ils devront travailler en étroite collaboration avec l’AI Office de l’UE et avec les régulateurs industriels et sectoriels existants, qui aujourd’hui sont déjà responsables du marquage CE, par exemple. Aux Pays-Bas, l’Autoriteit Persoonsgegevens joue clairement un rôle de pionnier dans la mise sur pied d’une autorité néerlandaise de l’IA, qui sera probablement établie dans le giron de l’Autoriteit Persoonsgegevens. En Belgique, la situation reste calme, même si le temps presse. En effet, on ne peut pas non plus engager n’importe qui pour occuper ces fonctions assez spécialisées.

Conclusion

Il est important de retenir que l’AI Act n’impose aucune restriction aux systèmes d’IA à faible risque, à l’exception de l’IA à usage général qui requiert la transparence nécessaire. Ce n’est que pour les systèmes à risques élevés ou systémiques et mis en production qu’interviennent des exigences strictes et la nécessité de se conformer aux réglementations pertinentes. Même dans ce cas, de nombreuses mesures d’atténuation offrent une marge de manœuvre supplémentaire au développement interne, aux initiatives open source, à la science, à la défense, etc.

Dans une certaine mesure, l’AI Act se veut concret, par une énumération détaillée des attentes et la mention de diverses précisions dans les considérants et les annexes. Il y parvient en partie et devient ainsi assez technique, de sorte qu’un juge concerné devra apprendre ce que sont les FLOPS. Parallèlement, il subsiste de nombreuses lacunes à combler et il reste à voir où le nouvel AI Office placera la barre dans les futures Commissions. La possibilité de modifier ultérieurement l’IA Act a été envisagée ici et là. La version actuelle de l’IA Act ne sera donc certainement pas la dernière.

Enfin, en Belgique, il ne s’agit pas d’attendre trop longtemps pour désigner et organiser le(s) régulateur(s) national(aux) pour l’AI Act si l’on veut être un tant soit peu en phase avec le reste de l’Europe. Pour obtenir des outils pratiques qui peuvent, entre autres, vous aider à vous mettre en conformité, vous pouvez d’ores et déjà consulter la base de données du Kenniscentrum Data & Maatschappij. De nombreux autres documents y seront certainement publiés lorsque l’AI Act entrera effectivement en vigueur.

______________________

Cette contribution a été soumise par Joachim Ganseman, consultant IT chez Smals Research. Elle a été rédigée en son nom propre et ne prend pas position au nom de Smals.