Vers une intelligence artificielle plus éthique

L’intelligence artificielle (IA) comme toute nouvelle technologie révolutionnaire est source de nombreuses innovations destinées à nous faciliter la vie. Cependant, cette technologie peut aussi avoir un impact négatif sur nos vies si elle est développée sans précaution ou à des fins malveillantes (voir AI en desinformatie). Si nous voulons réussir cette révolution numérique et si nous voulons qu’elle serve le plus grand nombre, en particulier dans le secteur publique, il est important d’adopter l’éthique by design. Il est d’autant plus efficace de considérer l’éthique en début de projet d’IA, qu’il est difficile de corriger un système pour le rendre éthique une fois implémenté, sans compter les dégâts en terme d’images quand les algorithmes déraillent.

L’ IA suscite beaucoup d’enthousiasme notamment pour les algorithmes décisionnels car ils sont supposés palier aux biais et erreurs de jugement humain. Adoptés par les instances publiques dans les cours de justices, pour l’attribution des écoles, etc. ils se sont révélés délétères pour des groupes dits sensibles comme illustrés dans le livre à succès « Weapons of Math Destruction »[1] (les faits décrits se déroulent aux États-unis). Ces algorithmes décisionnels sont en majorité basés sur l’apprentissage automatique (ou machine learning) c.-à-d. que les règles de décision ne sont pas formellement décrites dans le code, le modèle de décision est appris de façon autonome par le système à partir de données historiques donnant une impression d’objectivité. Cependant, l’algorithme réplique les biais implicites présents dans les données ou dans les choix de design adoptés par les humains. Pour reprendre quelques exemples abondamment cités : on retrouve des biais dans les algorithmes de reconnaissance faciale qui se trouvent être beaucoup moins performant sur des visages de femmes à la peau fonçée que sur des visages d’hommes à la peau claire (voir Gender Shades : Intersectionnal Accuracy Disparities in Commercial Gender Classification), ou encore les biais de genre présents dans le concept de word embedding[2] utilisé par les algorithmes pour traiter les données textuelles (voir Man is to Computer Programmer as Woman is to Homemaker?).

Qu’est-ce qu’une IA éthique ?

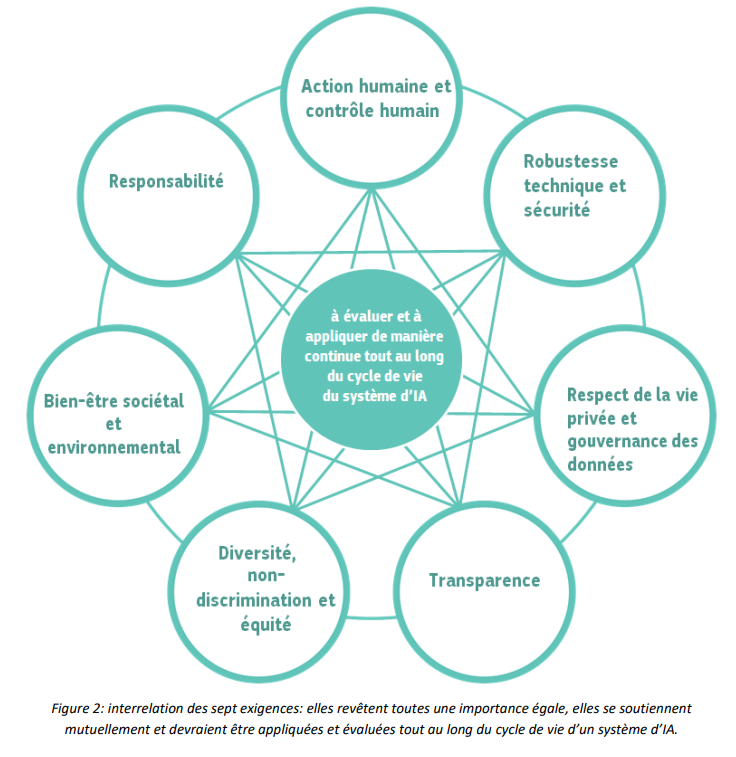

L’Union européenne tient à se démarquer sur le terrain de l’IA en faisant de l’éthique un élément essentiel du développement d’une IA de pointe. Elle a défini pour cela un cadre sous forme de lignes directrices en matière d’éthique pour une IA de confiance (Ethics Guidelines for Trustworthy AI) qui reposent sur les éléments suivants:

- Le respect des législations et règlementations applicables – licite

- L’adhésion à des principes et valeurs éthiques – éthique

- Sur le plan technique et social, l’IA ne peut causer de préjudices involontaires – robuste

Une IA éthique y est définie, comme une IA développée dans le respect des droits fondamentaux qui respectent les principes suivants :

- Respect de l’autonomie. Les êtres humains qui interagissent avec des systèmes d’IA doivent être en mesure de conserver leur autodétermination totale et effective.

- Prévention de toute atteinte. L’IA ne doit pas nuire aux êtres humains.

- Équité. Il s’agit d’un côté d’éviter les biais injustes, la discrimination et la stigmatisation de certains groupes ou individus et de l’autre de mettre en place des procédures qui permettent de contester les décisions prises par l’IA et d’introduire un recours à l’encontre de ces décisions.

- Explicabilité. Les systèmes d’IA doivent être transparents et les décisions prises à l’aide de ces systèmes doivent pouvoir être expliquées.

Quel est l’origine des biais présents dans les algorithmes?

Un biais (négatif) est une distorsion dans le fonctionnement de l’algorithme dont le résultat est de désavantager systématiquement un groupe d’individus identifiés par des attributs « sensibles » tels que le genre, l’orientation politique, l’ethnicité, etc.

Les biais se retrouvent principalement dans les données utilisées pour construire un modèle et/ou dans le design du modèle. Ils résultent des situations suivantes :

- Une mauvaise méthode de collections de données. Les données ne reflètent pas la réalité, il y a un problème de sous-représentation d’un groupe de personnes, d’objets…

- Les données sont correctement collectées mais elles contiennent des biais structurels. Par exemple, si l’on collecte des données sur l’emploi et que historiquement, certains jobs sont systématiquement attribués aux hommes plutôt qu’aux femmes.

- La mauvaise catégorisation par l’être humain des données nécessaires pour le développement d’un modèle de classification en apprentissage supervisé.

- Le mauvais design des algorithmes. Les algorithmes ne sont pas neutres et reflètent les valeurs de ceux qui les conçoivent. Les biais humains se manifestent alors dans le choix du type de données que l’on intègre dans le modèle, la transformation que l’on opère sur ces données, le poids qu’on leur attribue, etc.

- L’algorithme décisionnel est semi-automatique, la décision finale revient à l’humain cependant celui-ci peut mal interpréter les résultats produits par l’algorithme et introduire des biais.

Comment supprimer les biais ?

Plusieurs techniques ont été développées pour mesurer et prévenir les biais algorithmiques (celles-ci seront abordées dans un prochain blog) néanmoins la technique seule ne suffit pas. On peut intégrer l’éthique dans le développement et le déploiement d’un système d’IA en adoptant quelques principes:

- Avant de commencer un projet d’IA, évaluer les risques et l’impact liés à l’algorithme que l’on veut déployer en impliquant les acteurs techniques, les personnes directement affectées par l’algorithme et ceux qui l’utilisent. Cet évaluation du risque doit se poursuivre tout au long du cycle de vie du système d’IA.

- Assurer la diversité dans les personnes impliquées dans le développement et l’implémentation de l’algorithme.

- Se fixer des objectifs clairs quant aux biais qu’on veut mitiger/supprimer dans un certain contexte légal.

- Identifier des métriques (avec les équipes techniques) qui permettent de mesurer ces biais.

- Assurer la transparence, les décisions prises par un algorithme doivent pouvoir être expliquées. Il est important de connaître les éléments qui ont été déterminants dans la prise de décision en particulier surtout si les choses tournent mal. Ceci limite l’utilisation d’algorithmes tels que les réseaux de neurones ou l’utilisation d’algorithmes de partis tierces dont la propriété intellectuelle est protégée.

- Assurer la robustesse des algorithmes, par ex. en vérifiant que l’algorithme réagit de manière adéquate quand on modifie légèrement les données en entrée. En outre dans deux situations similaires, l’algorithme doit donner une décision similaire. Dans le secteur public, cela garantit que tout citoyen est traité de la même façon.

- Monitorer les algorithmes, les ré-entraîner régulièrement sur de nouvelles données en prenant garde à ne pas amplifier des éventuels biais par un processus de feedback loop ( les décisions prises avec un algorithme affectent les nouvelles données qui sont elles-mêmes utilisées pour générer une nouvelle version de cet algorithme).

- Auditer les algorithmes, cependant il n’y a pas encore de règles claires quant à la façon dont les algorithmes doivent être auditer.

Quid de l’utilisation d’algorithmes développés par des parties tierces. Le fonctionnement de ces technologies et les risques qu’elles comportent sont opaques, les valeurs des personnes qui les développent ne sont pas forcément en accord avec les valeurs promues par ceux qui les utilisent.

Quel cadre légal?

Il existe une loi européenne de non-discrimination qui permet de garantir un traitement équitable à tous les individus néanmoins celle-ci est difficile à faire appliquer dans le domaine de l’IA. Il est en effet difficile de démontrer qu’il y a eu discrimination par l’algorithme. De plus, étant donné son approche contextuelle laissant la place à une interprétation juridique ouverte et reposant fortement sur l’intuition, ces lois de non-discrimination ne sont pas assez homogènes pour être intégrées dans un système automatisé(Why fairness cannot be automated: bridging the gap between EU non-discrimination law and AI).

L’UE montre cependant de grandes ambitions en terme de protections des individus. Après avoir introduit le RGPD, un des plus grands avancements en terme de protection de données, la commission européenne a publié en avril dernier une proposition de cadre juridique sur l’IA centrée sur les risques. Plusieurs catégories de risques y sont définies avec pour chaque catégorie des obligations légales différentes. Par exemple, un système d’IA dédié au tri pour le recrutement sera classé « à risque élevé » avec comme obligations (entre autres) une évaluation de risque, une documentation détaillée, la traçabilité des résultats, etc.

Pour conclure, dans le secteur public comme dans le secteur privé l’adoption de l’IA est inévitable. Étant donné l’impact de l’IA sur la société, il faut dès le départ développer une vraie stratégie d’IA éthique. Les algorithmes doivent être équitables et être perçus comme tels. Pour cela il faut informer les citoyens, les aider à comprendre l’impact des algorithmes et leur faciliter le processus de contestation de décisions qui les impactent. Une IA éthique aiderait à retrouver un certain équilibre entre défiance totale et optimisme exagéré.

[1] O’Neil Cathy. “Weapons of Math Destruction“. Crown Books, 2016

[2] Permet de représenter en mot de façon contextuelle, deux mots ayant une signification similaire auront une représentation similaire qui se traduit par une vecteur numérique

Ce post est une contribution individuelle de Katy Fokou, spécialisée en intelligence artificielle chez Smals Research. Cet article est écrit en son nom propre et n’impacte en rien le point de vue de Smals.